Manual de operación plataforma VIVAit

| Producto: | VIVAit Call

VIVAit Suite |

|---|

Sumario

- 1 Introducción

- 2 Arquitectura

- 3 Descripción de los elementos, diagnósticos y operaciones

- 3.1 Versiones de módulos

- 3.2 Sistema Operativo

- 3.3 Matriz de conmutación

- 3.4 Servicios networking

- 3.5 Bases de datos (BBDD)

- 3.6 Procesos propios

- 3.6.1 bdCentral

- 3.6.2 bdNodo

- 3.6.3 Intz-Nimitz

- 3.6.4 motorSal

- 3.6.5 MyACDSuperv

- 3.6.6 proceso escoba

- 3.6.7 recordCentral

- 3.6.8 recordNodo

- 3.6.9 Vivait-CTI

- 3.6.10 Phoneprov-TFTP

- 3.6.11 Introducción al aprovisionamiento

- 3.7 Requerimientos de conectividad

- 3.8 Gateways

- 3.9 Servidor de grabación

- 3.10 Reporting

- 4 Otros Diagnósticos y operaciones básicas

- 4.1 Arranque y apagado de la plataforma

- 4.2 Grabación

- 4.2.1 Configuración de la grabación en la plataforma corporativa

- 4.2.2 Comprobación de que el servidor de grabación esta activo

- 4.2.3 Comprobación de que los nodos están conectados al servidor de grabación

- 4.2.4 Comprobación de que un nodo tiene activo el agente de grabación

- 4.2.5 Comprobación de que un nodo está subiendo archivos de grabación al servidor

- 4.2.6 Comprobación de grabaciones que se hayan quedado enganchadas en un nodo

- 4.2.7 Comprobación del estado de ocupación del almacenamiento temporal de grabaciones en un nodo.

- 4.3 Escuchas e intrusiones en asterisk

- 4.4 Calendarios

- 4.5 Syslog de agentes

- 5 Funcionalidades específicas

- 6 Puesto de trabajo

- 7 Funcionamiento de la plataforma en modo emergencia

- 8 Accesos Web

- 9 Elementos monitorizados del sistema

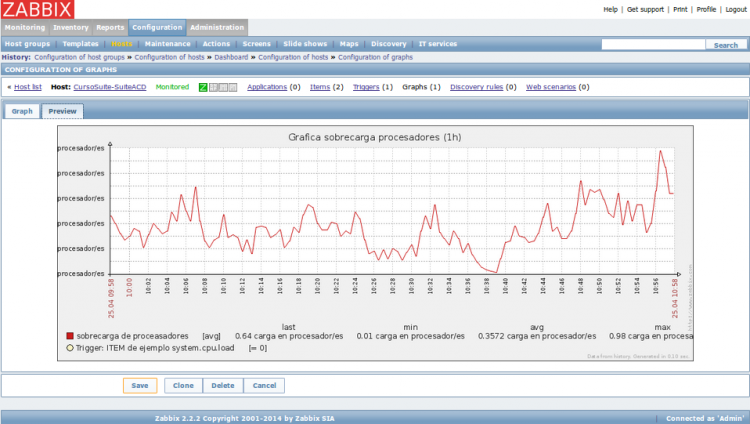

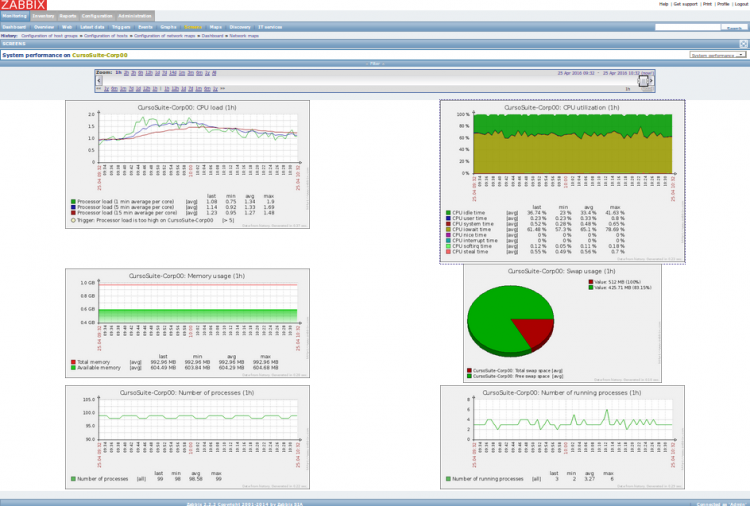

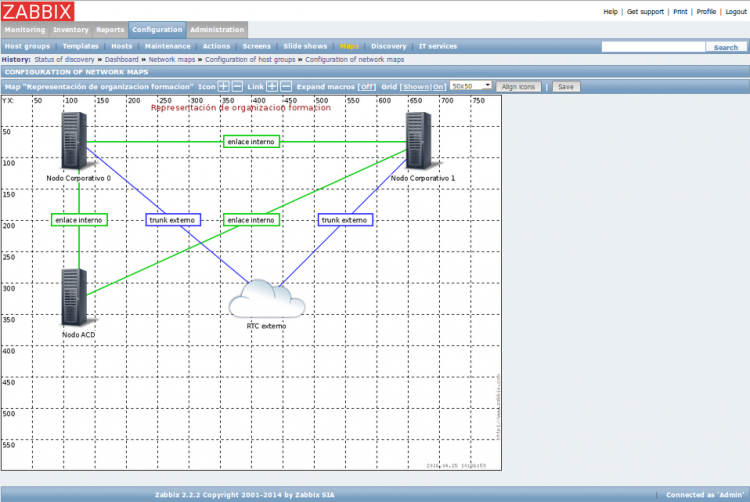

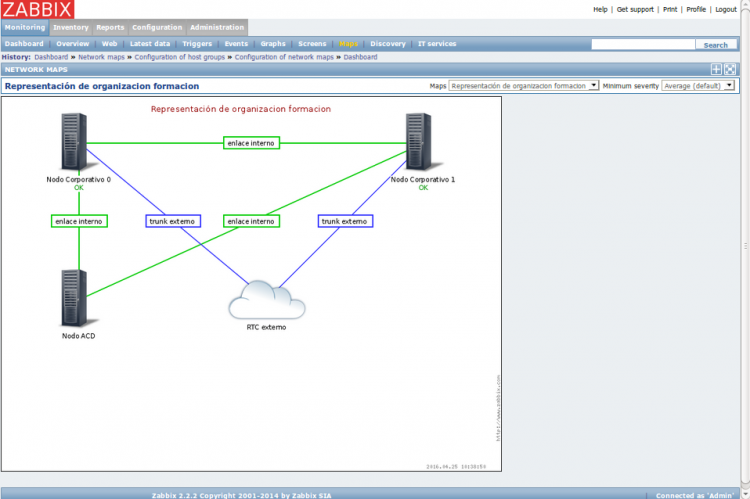

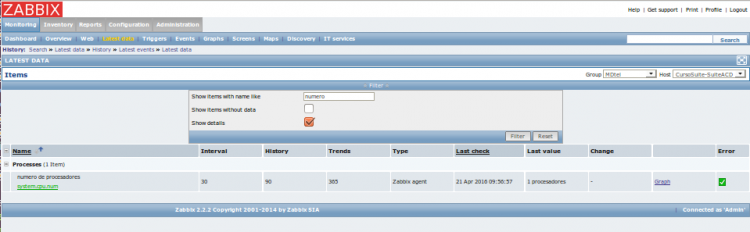

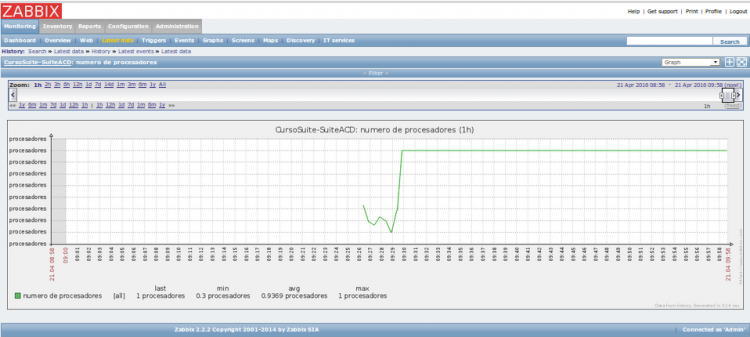

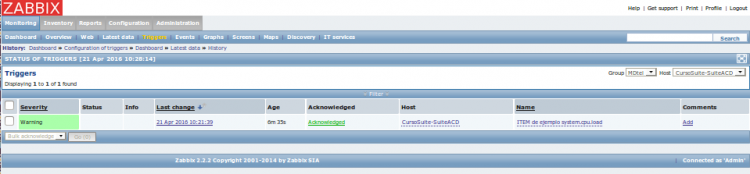

- 9.1 Generalidades de Zabbix

- 9.2 Zabbix en MDtel

- 9.2.1 Configuraciones de Zabbix

- 9.2.1.1 Agentes Zabbix

- 9.2.1.2 Scripts del Servidor Zabbix

- 9.2.1.2.1 zabbixSenderACDBD.pl

- 9.2.1.2.2 zabbixSenderACD.pl

- 9.2.1.2.3 zabbixSenderCTI.pl

- 9.2.1.2.4 zabbixSender-intz-nimitz.pl

- 9.2.1.2.5 zabbixSenderMotorSal.pl

- 9.2.1.2.6 zabbixSenderMyACDSuperv.pl

- 9.2.1.2.7 zabbixSenderRecordNodo.pl

- 9.2.1.2.8 zabbixSenderRecordCentral.pl

- 9.2.1.2.9 Dimensionamiento del servidor (Startpollers)

- 9.2.1.3 Templates

- 9.2.1 Configuraciones de Zabbix

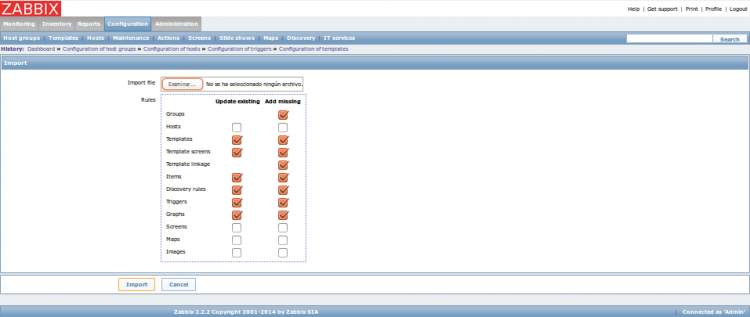

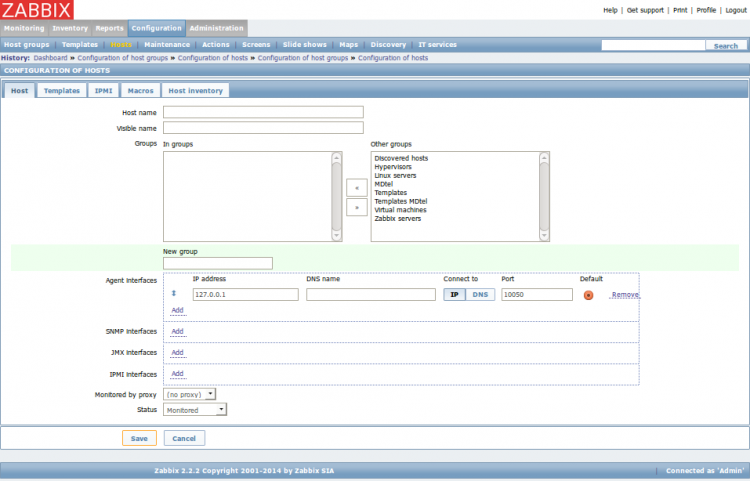

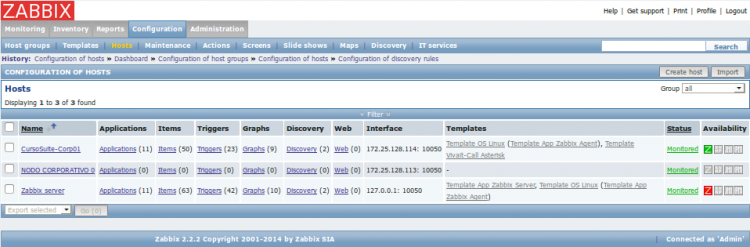

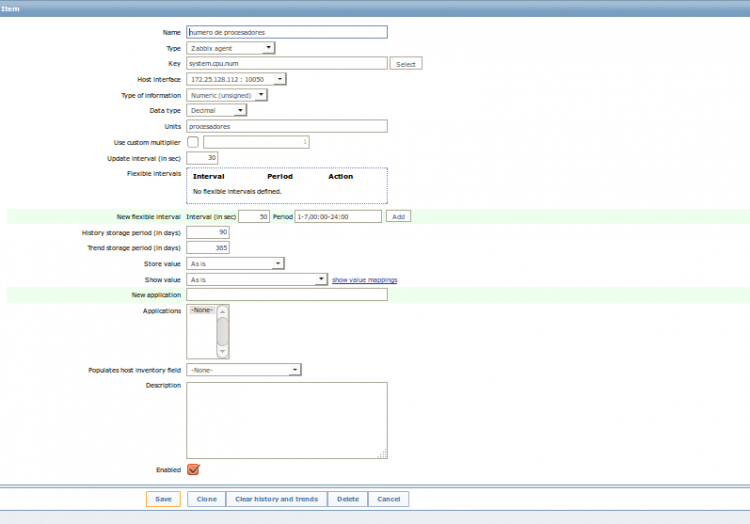

- 9.3 Configuración para un primer funcionamiento de Zabbix

- 10 Integraciones con servicios externos

1 Introducción

En este documento se describe la arquitectura general de la plataforma VIVAit, detallando aquellos procesos principales que componen cada uno de los elementos del sistema, y sus principales elementos de diagnóstico Quedan fuera del ámbito de este documento:

- Uso de aplicación de agente (VIVAit Desk)

- Uso de aplicación de supervisor (VIVAit Supervisor), incluyendo sus módulos autónomos (VIVAit reporting, VIVAit Tracker)

- Uso de portal de administración

- Uso de portal de traceo de llamadas y agentes (VIVAit Tracker web)

- Uso de portal de monitorización zabbix

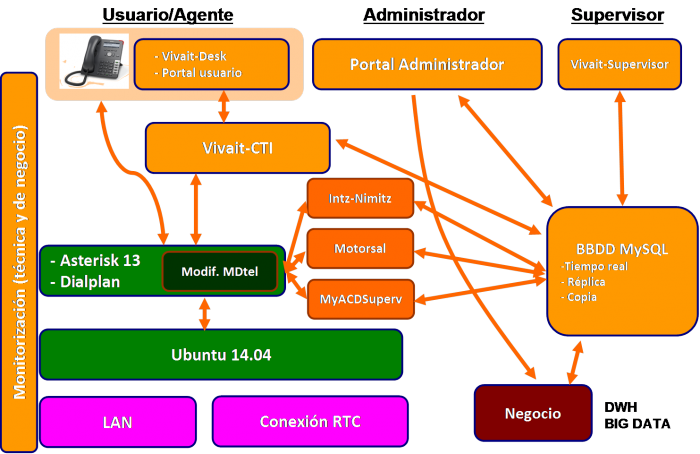

2 Arquitectura

3 Descripción de los elementos, diagnósticos y operaciones

Las siguientes tablas definen los principales elementos software de la plataforma VIVAit, que son detallados en apartados siguientes:

| Elemento | Instancias | Propósito | Producto | Observaciones |

|---|---|---|---|---|

| Ubuntu Server LTS 64 bits | Uno por servidor | VIVAit Call

VIVAit Suite |

Actualmente (Oct-2015) 14.04

Bajo proyecto puede cambiarse | |

| Almacenamiento de grabaciones | Uno por sistema | Almacenamiento de las grabaciones, ya sean de entorno corporativo o de contact center | VIVAit Call

VIVAit Suite |

Típicamente un espacio grande de almacenamiento proporcionado por el cliente y que se monta como un sistema de archivos local en los servidores de la plataforma

Pueden existir sistemas secundarios de almacenamiento de grabaciones |

| Elemento | Instancias | Propósito | Producto | Observaciones |

|---|---|---|---|---|

| Asterisk 1.4.24 by MDtel | Uno por servidor ACD | Núcleo de conmutación de voz basado en Asterisk 1.4 y modificado por MDtel | VIVAit Suite | Fuertemente modificado por MDtel

En el futuro migrará a Asterisk 13 Certified |

| Dialplan ACD by MDtel | Uno por servidor ACD | Configuración de voz | VIVAit Suite | En el futuro se unificará con corporativa |

| Asterisk 13 Certified by MDtel | Uno por servidor corporativo/gateway | Núcleo de conmutación de voz basado en Asterisk 13 y modificado por MDtel | VIVAit Call

VIVAit Suite |

Actualmente asterisk estándar (10/15)

La instalación contempla descargar de la red el más actualizado, siempre CERTIFIED" |

| Dialplan corporativo | Uno por servidor corporativo/gateway | Configuración de voz | VIVAit Call

VIVAit Suite |

En el futuro se unificará con ACD |

| Elemento | Instancias | Propósito | Producto | Observaciones |

|---|---|---|---|---|

| MySQL 5.5 | Donde haya BBDD de cualquier tipo (incluso zabbix) | Motor de Base de Datos | VIVAit Call

VIVAit Suite |

A efectos prácticos va a ser en todos los servidores con casi total seguridad |

| BBDD tiempo real | Una por sistema | Base de Datos sobre la que trabaja todo el entorno de tiempo real | VIVAit Call

VIVAit Suite | |

| BBDD réplica | Una por sistema multinodo | Base de Datos para acceso a información de reporting…y similar | VIVAit Call

VIVAit Suite |

Bajo proyecto puede existir más de una

En el nodo en el que exista réplica existirá además copia (excepto nodo ACD) |

| BBDD copia | Uno por servidor corporativo/gateway | Copias de tablas de configuración para respaldo de la misma | VIVAit Call

VIVAit Suite |

Local en cada nodo

Los nodos de ACD actualmente no trabajan con copia; en caso de fallo de BBDD TR se usa el modo emergencia |

| Elemento | Instancias | Propósito | Producto | Observaciones |

|---|---|---|---|---|

| Intz-Nimitz | Donde haya una BBDD de tiempo real o copia | Interfaz entre el dialplan y la base de datos | VIVAit Call

VIVAit Suite |

No donde haya BBDD de réplica

Sistemas grandes pueden contemplar mas de un intz-nimitz central" |

| vivait-cti | Uno por servidor ACD | Interfaz entre VIVAit Desk, supervisor y el manager de asterisk | VIVAit Suite | |

| myAcdSuperv | Uno por servidor ACD | Recopilador de datos de asterisk y actualiza en la BBDD

Genera llamadas en el marcador |

VIVAit Suite | |

| motorSal | Uno por sistema con ACD | Motor de marcador saliente automático | VIVAit Suite | Solo si hay marcación saliente

Junto a la BBDD de tiempo real |

| recordCentral | Uno por sistema | Servidor de grabaciones, se conectan los agentes a el | VIVAit Call

VIVAit Suite |

Se arrancan varias instancias en función del número de nodos

Debe instalarse en un servidor que tenga el almacenamiento de grabaciones en su sistema de archivos |

| recordNodo | Uno por servidor corporativo/gateway | Agente de grabación | VIVAit Call

VIVAit Suite |

|

| bdCentral | Uno, en el nodo con la BBDD de tiempo real | Genera la base de datos que se copiará para respaldo a otros nodos | VIVAit Call

VIVAit Suite |

|

| bdNodo | En cada nodo con BBDD de copia | Recoge la base de datos del servidor central con el objeto de tener el respaldo | VIVAit Call

VIVAit Suite |

|

| Actualizador | Uno por sistema con ACD | Se encarga de proporcionar las versiones actualizadas de las aplicaciones de puesto de trabajo | VIVAit Suite | En el mismo servidor que el portal de administración |

| phoneProv-tftp | Uno por sistema | Se encarga del aprovisionamiento masivo de terminales | VIVAit Call

VIVAit Suite |

En instalaciones grandes habrá más de uno, quizás uno por sede grande; depende de la infraestructura de DHCP |

| borraregistrosnimitz | ||||

| Mover grabaciones a nube |

| Elemento | Instancias | Propósito | Producto | Observaciones |

|---|---|---|---|---|

| Tomcat 7 | Uno por servidor con portales | Servidor de aplicaciones JAVA | VIVAit Call

VIVAit Suite | |

| Portal de administración | Uno por sistema | Portal de administración del sistema | VIVAit Call

VIVAit Suite |

Bajo proyecto puede existir más de uno |

| Portal usuario | Uno por sistema | Portal de usuario, para acceso a buzones, su configuración | VIVAit Call | Bajo proyecto puede existir más de uno |

| Tracker web | Uno por sistema | Portal de seguimiento de llamadas | VIVAit Call

VIVAit Suite |

Debe instalarse en un servidor que tenga los ficheros de grabación montados en su sistema de archivos

Ligado a recordCentral Bajo proyecto puede existir más de uno |

| Monitor | Uno por sistema | Portal de monitores de pared de Call Center | VIVAit Suite | Bajo proyecto puede existir más de uno |

| Apache | Uno por servidor de calendarios | Servidor de portales WEB | VIVAit Call

VIVAit Suite |

|

| Servidor de calendarios | Uno por sistema | Aloja calendarios para su uso en diferentes entornos de NIMITZ | VIVAit Call

VIVAit Suite |

Bajo proyecto puede existir más de uno |

| Elemento | Instancias | Propósito | Producto | Observaciones |

|---|---|---|---|---|

| Servidor zabbix | Uno por instalación | Monitorización técnica y de negocio | VIVAit Call

VIVAit Suite |

Bajo proyecto puede existir más de uno

Tipicamente irá o en BBDD replica o en nodo de gestión en instalaciones grandes |

| Templates zabbix | Uno por instalación | Adaptaciones específicas | VIVAit Call

VIVAit Suite |

|

| Agente Zabbix | Uno por servidor | Agente de monitorización | VIVAit Call

VIVAit Suite |

|

| Scripts monitorización zabbix | Uno por servidor | Agente de monitorización | VIVAit Call

VIVAit Suite |

3.1 Versiones de módulos

| Módulo | V.3.10 | V.3.2.0 | V.3.3.0 | V.3.4.0

(VSuite 3.4+VCall3.3) |

|---|---|---|---|---|

| Asterisk | 1.4 | 1.4 | 1.4 | 1.4 Nodo ACD

13 resto nodos |

| Asterisk ACD | 3.3.1 | |||

| Dialplan ACD | ||||

| Asterisk Corp | 3.3.4 | |||

| Dialplan Corp | 3.3.1 | |||

| Lazarus común | 3.1.0 | 3.2.0 | 3.3.0 | 3.4.0 |

| BD | 3.2.0 | 3.4.0 | 3.5.0 | 3.6.0 |

| Generaconf | 3.0.0 | 3.0.0 | 3.2.0 | 3.4.0 |

| Instalador | 3.1.0 | 3.2.0 | 3.3.0 | 3.4.0 |

| Intz-nimitz | 2.6.0 | 3.0.1 | 3.0.3 | 3.4.1 |

| recordgwd | 1.3.0 | 1.3.0 | 3.1.0 | ----- |

| recordNodo | ----- | ----- | ----- | 4.0.0 |

| recordprocesad | 1.2.0 | 1.2.0 | 3.0.0 | ----- |

| recordCentral | ----- | ----- | ----- | 4.0.0 |

| MyACDSuperv | 5.2.0 | 5.3.0 | 5.3.0 | 5.3.2 |

| Motorsal | 1.4.0 | 3.1.0 | 3.2.0 | 3.3.0 |

| F | 3.0.0 | 3.0.1 | 3.0.1 | 3.0.1 |

| Multimonitorweb | 3.0.1 | 3.0.2 | 3.1.0 | 3.1.0 |

| Portal de administración | 3.1.0 | 3.2.0 | 3.3.0 | 3.4.0 |

| Tracker Web | 3.0.2 | 3.1.0 | 3.2.0 | 3.3.0 |

| VIVA supervisor | 3.0.0 | 3.1.0 | 3.2.0 | 3.3.0 |

| Tracker windows | 3.0.0 | 3.1.0 | 3.2.0 | 3.3.0 |

| VIVA report | 1.2.0 | 3.1.0 | 3.2.0 | 3.2.2 |

| VIVA desk | 3.0.2 | 3.2.0 | 3.3.0 | 3.4.0 |

| VIVA designer | 1.0.23 | 3.0.1 | 3.1.0 | 3.1.0 |

| Preview | 1.0.18 | 3.2.0 | 3.3.0 | 3.4.0 |

| Phone_prov | ------ | ------ | 3.0.1 | 3.0.3 |

| Portal usuario | ------ | ------ | ------ | 3.0.0 |

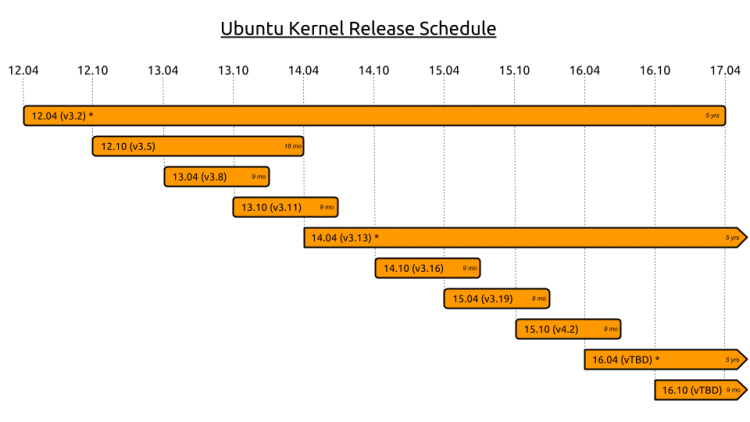

3.2 Sistema Operativo

Los sistemas operativos de nuestra plataforma se corresponden a las versiones de Ubuntu Server LTS , ya que son las versiones estables, con un soporte continuado y mas estables a actualizaciones desde la salida Ubuntu 14.04.1. En concreto el sistema operativo utilizado para la plataforma VIVAit es Ubuntu Server 14.04.4 LTS. Para más información https://help.ubuntu.com/lts/serverguide/index.html.

3.2.1 Funcionamiento en cluster

En caso de existir funcionamiento en cluster se basa en:

- Heartbeat: IP flotante entre las dos máquinas que componen el cluster; típicamente este "latido" entre máquinas se realizará mediante conexión directa con cable cruzado para asegurar que no existan problemas de comunicaciones tales como retardo, pérdida de paquetes, etc en este latido y pueda ser causa de un balanceo inadecuado.

| Nota 17-11-2015: Se ha realizado en un cliente un cluster distribuido, con dos servidores en diferentes sedes, realizando el heartbeat mediante enlace Gigabit. Si bien la solución no está validada por desarrollo, se está observando el funcionamiento. |

- DRBD que se encargar de mantener una serie de carpetas totalmente replicadas entre los dos nodos; dichas las carpetas son:

El cluster es activo/pasivo; la máquina activa posee la IP flotante y tiene arrancados los servicios.

3.2.2 Configuración del cluster

Para montar un cluster de asterisk partimos de la siguiente situación inicial:

- Dos maquinas con VIVAit Call 3.0 instalado.

- El driver bonding de Interfaces de Red en Ubuntu Server.

Los pasos a seguir para la configuración en el Ubuntu Server son los siguientes:

- Instalar ifenslave:

aptitude install ifenslave.

- Finalizada la instalación, comprobamos que la instalación de Bonding se ha configurado para empezar desde el arranque del sistema operativo desde el fichero /etc/modules:

vi /etc/modules # /etc/modules: kernel modules to load at boot time. # # This file contains the names of kernel modules that should be loaded # at boot time, one per line. Lines beginning with "#" are ignored. # Parameters can be specified after the module name. lp rtc bonding

- Crear o editar el archivo llamado /etc/modprobe.d/bonding.conf y añadir la siguiente linea en negrita:

echo "alias bond0 bonding"> /etc/modprobe.d/bonding.conf

- Editar el fichero /etc/network/interfaces y añadir lo que esta en negrita:

# This file describes the network interfaces available on your system # and how to activate them. For more information, see interfaces(5). # The loopback network interface auto lo iface lo inet loopback # Bonding #em1 ip manual y esclavo en el "bond0" NIC auto em1 iface em1 inet manual bond-master bond0 bond-primary em0 #em2 ídem, creando así un vínculo de enlace 2. auto em2 iface em2 inet manual bond-master bond0 auto bond0 iface bond0 inet static address 10.255.255.11 netmask 255.255.255.0 gateway 10.255.255.254 bond-mode active-backup bond-miimon 100 bond-slaves none # em3 replica entre servidores auto em3 iface em3 inet static address 10.255.254.10 netmask 255.255.255.0 # em4 gestion auto em4 iface em4 inet static address 172.17.47.255 netmask 255.255.0.0

- Reiniciamos el sistema para que el kernel tome los cambios.

- Comprobación que en las dos maquinas el archivo /etc/host contenga el los nombre de las dos maquinas a vincular. En el ejemplo el archivo en ambas maquinas es:

127.0.0.1 localhost 10.255.255.11 vivaitcall-CL-UAH-1 10.255.255.12 vivaitcall-CL-UAH-2 10.255.255.10 vivaitcall-CL-UAH 10.255.255.10 BDTR 10.255.254.10 vivaitcall-CL-UAH-1-em3 10.255.254.11 vivaitcall-CL-UAH-2-em3

- Creamos dos particiones iguales en ambos ordenadores , usando el comando parted.

root@vivaitcall-CL-UAH-1:~# parted /dev/sda GNU Parted 2.3 Using /dev/sda Welcome to GNU Parted! Type 'help' to view a list of commands. (parted) p free Model: HP LOGICAL VOLUME (scsi) Disk /dev/sda: 1000GB Sector size (logical/physical): 512B/512B Partition Table: gpt Number Start End Size File system Name Flags 17,4kB 262kB 245kB Free Space 1 262kB 1000MB 1000MB fat32 boot 2 1000MB 201GB 200GB ext4 3 201GB 217GB 16,0GB linux-swap(v1) 4 217GB 237GB 20,0GB ext4 237GB 1000GB 763GB Free Space (parted) mkpart primary 237GB 1000GB (parted) p free Model: HP LOGICAL VOLUME (scsi) Disk /dev/sda: 1000GB Sector size (logical/physical): 512B/512B Partition Table: gpt Number Start End Size File system Name Flags 17,4kB 262kB 245kB Free Space 1 262kB 1000MB 1000MB fat32 boot 2 1000MB 201GB 200GB ext4 3 201GB 217GB 16,0GB linux-swap(v1) 4 217GB 237GB 20,0GB ext4 5 237GB 1000GB 763GB primary No File System como ext4 1000GB 1000GB 204kB Free Space (parted)quit mkfs.ext4 /dev/sda5 root@vivaitcall-CL-UAH-1:~# parted /dev/sda GNU Parted 2.3 Using /dev/sda Welcome to GNU Parted! Type 'help' to view a list of commands. (parted) p free Model: HP LOGICAL VOLUME (scsi) Disk /dev/sda: 1000GB Sector size (logical/physical): 512B/512B Partition Table: gpt Number Start End Size File system Name Flags 17,4kB 262kB 245kB Free Space 1 262kB 1000MB 1000MB fat32 boot 2 1000MB 201GB 200GB ext4 3 201GB 217GB 16,0GB linux-swap(v1) 4 217GB 237GB 20,0GB ext4 5 237GB 1000GB 763GB primary 1000GB 1000GB 204kB Free Space (parted) rm 5 (parted) mkpart primary 237GB 1000GB (parted) p free Model: HP LOGICAL VOLUME (scsi) Disk /dev/sda: 1000GB Sector size (logical/physical): 512B/512B Partition Table: gpt Number Start End Size File system Name Flags 17,4kB 262kB 245kB Free Space 1 262kB 1000MB 1000MB fat32 boot 2 1000MB 201GB 200GB ext4 3 201GB 217GB 16,0GB linux-swap(v1) 4 217GB 237GB 20,0GB ext4 5 237GB 1000GB 763GB ext4 primary Si File Sytem ext4 1000GB 1000GB 204kB Free Space (parted)quit

- Instalar los paquetes necesarios para el drbd. En Ubuntu server 14.04 ya está instalado.

aptitude install drbd8-utils aptitude update (si no instala el drbd8-utils actualizar) aptitude install drbd8-utils (volver a lanzar)

- Creamos el archivo /etc/drbd.conf en ambas maquinas:

# You can find an example in /usr/share/doc/drbd.../drbd.conf.example include "drbd.d/global_common.conf"; include "drbd.d/*.res"; resource MDcluster { protocol C; on vivaitcall-CL-UAH-1 { device /dev/drbd0; disk /dev/sda5; address 10.255.254.10:7788; meta-disk internal; } on vivaitcall-CL-UAH-2 { device /dev/drbd0; disk /dev/sda5; address 10.255.254.11:7788; meta-disk internal; } disk { on-io-error detach; } net { max-buffers 2048; ko-count 4; } syncer { rate 100M; al-extents 257; } startup { wfc-timeout 0; degr-wfc-timeout 120; } }

- Reiniciamos el sistema para que el kernel tome los cambios.

- Inicializamos el recurso, para ello primero deberemos crear los recursos DRBD teclearemos en ambas maquinas. Desde /etc.

drbdadm create-md MDcluster (no y yes )

- Si tenemos algún problema porque ya exista sistema de ficheros.

dd if=/dev/zero of=/dev/sda5 bs=1M count=128 drbdadm create-md MDcluster (no y yes )

- Reiniciamos ambas maquinas para que su kernel tome los cambios.

- Levantamos el servicio del DRBD en ambos servidores (nos preguntara que si queremos enviar los datos a los desarrolladores de drbd) tecleando no, no se envían.

service drbd start /etc/init.d/drbd start

- Ahora ambas maquinas son secundarias.

- Indicar cual de las dos maquinas usaremos como primaria, por tanto en la maquina elegida habra que ejecutar:

drbdadm -- --overwrite-data-of-peer primary all (en una máquina)

- Nota: La ip virtual que va a estar asignada a la maquina activa es 172.25.129.70.

- Podemos teclear el comando cat para ver si esta sincronizando y su progreso:

cat /proc/drbd Nota: El servicio DRBD aparecera como Primary/Secondary si ejecutamos en el primario ; y aparecerá 'Secondary/Primary' si lo ejecutamos en el secundario.

- Instalación de los script de arranque:

update-rc.d -f drbd remove (en las dos maquinas) update-rc.d drbd start 13 2 3 4 5 . stop 87 0 1 6 . (en las dos máquinas)

- Seleccionar la fuente de sincronización.

- Formateamos un disco de la maquina que queramos que funcione como fuente del servicio DRBD, para evitar conflictos:

mkfs.ext4 /dev/drbd0

- Creamos el directorio sobre el que vamos a montar el disco, en ambas maquinas.

mkdir /HDcluster

- Creamos un archivo dentro /HDcluster de que se verá solo cuando el disco no está montado en ambas maquinas.

touch sinMontar Nota: Este archivo nos puede servir para monitorizar mediante zabbix, nagios, ... que el disco no está montado.

- En una de las maquinas montamos el disco (desde fuera del directorio HDcluster)

mount /dev/drbd0 /HDcluster

- Procedemos a mover todos los datos que necesitemos en este disco y a crear accesos directos, los directorios que vamos a mover son los siguientes:

/etc/asterisk /var/lib/asterisk /usr/lib/asterisk /usr/spool/asterisk /var/lib/mysql /var/tftp/

- El procedimiento que vamos a seguir es el siguiente, en el primer ordenador:

Cd /HDcluster tar -zcvf etc-asterisk.tgz /etc/asterisk tar -zxvf etc-asterisk.tgz rm -rf /etc/asterisk ln -s /HDcluster/etc/asterisk /etc/asterisk tar -zcvf var-lib-asterisk.tgz /var/lib/asterisk tar -zxvf var-lib-asterisk.tgz rm -rf /var/lib/asterisk ln -s /HDcluster/var/lib/asterisk /var/lib/asterisk tar -zcvf usr-lib-asterisk.tgz /usr/lib/asterisk tar -zxvf usr-lib-asterisk.tgz rm -rf /usr/lib/asterisk ln -s /HDcluster/usr/lib/asterisk /usr/lib/asterisk tar -zcvf var-spool-asterisk.tgz /var/spool/asterisk tar -zxvf var-spool-asterisk.tgz rm -rf /var/spool/asterisk ln -s /HDcluster/var/spool/asterisk /var/spool/asterisk tar -zcvf var-lib-mysql.tgz /var/lib/mysql tar -zxvf var-lib-mysql.tgz rm -rf /var/lib/mysql ln -s /HDcluster/var/lib/mysql /var/lib/mysql tar -zcvf var-lib-phoneprov-tftp.tgz /var/lib/phoneprov-tftp/ tar -zxvf var-lib-phoneprov-tftp.tgz rm -rf /var/lib/phoneprov-tftp/ ln -s /HDcluster/var/lib/phoneprov-tftp /var/lib/phoneprov-tftp

- En la segunda maquina debemos borrar los directorios y crear los accesos directos.

rm -rf /etc/asterisk ln -s /HDcluster/etc/asterisk /etc/asterisk rm -rf /var/lib/asterisk ln -s /HDcluster/var/lib/asterisk /var/lib/asterisk rm -rf /usr/lib/asterisk ln -s /HDcluster/usr/lib/asterisk /usr/lib/asterisk rm -rf /var/spool/asterisk ln -s /HDcluster/var/spool/asterisk /var/spool/asterisk rm -rf /var/lib/mysql ln -s /HDcluster/var/lib/mysql /var/lib/mysql rm -rf /var/lib/phoneprov-tftp ln -s /HDcluster/var/lib/phoneprov-tftp /var/lib/phoneprov-tftp

- Configurar heartbeat para las dos maquinas.

- Instalamos heartbeat en las dos maquinas. En UBUNTU Server 14.04 ya está instalado.

aptitude install heartbeat

- Debemos modificar 3 ficheros en cada una de las maquinas, estos se encuentran en /etc/ha.d. El primer fichero a modificar es ha.cf.:

- En la maquina vivaitcall-CL-UAH-1 es:

root@vivaitcall-CL-UAH-1:~# cat /etc/ha.d/ha.cf # Explicacion en /usr/share/doc/heartbeat/ha.cf.gz udpport 694 baud 19200 auto_failback off use_logd yes crm no # Temporizaciones en segs logfacility local0 keepalive 2 deadtime 8 warntime 16 initdead 64 deadping 6 #ucast bond0 vivaitcall-CL-UAH-1 ucast bond0 vivaitcall-CL-UAH-2 #ucast em3 vivaitcall-CL-UAH-1-em3 ucast em3 vivaitcall-CL-UAH-2-em3 #Ping a puerta de enlace,gw1,gw2,gw3,gw4 ping_group red_local 10.255.255.12 respawn hacluster /usr/lib/heartbeat/ipfail apiauth ipfail gid=haclient uid=hacluster node vivaitcall-CL-UAH-1 node vivaitcall-CL-UAH-2

- Y en la maquina vivaitcall-CL-palacio-2 es:

root@vivaitcall-CL-UAH-1:~# cat /etc/ha.d/ha.cf # Explicacion en /usr/share/doc/heartbeat/ha.cf.gz udpport 694 baud 19200 auto_failback off use_logd yes crm no # Temporizaciones en segs logfacility local0 keepalive 2 deadtime 8 warntime 16 initdead 64 deadping 6 ucast bond0 vivaitcall-CL-UAH-1 #ucast bond0 vivaitcall-CL-UAH-2 ucast em3 vivaitcall-CL-UAH-1-em3 #ucast em3 vivaitcall-CL-UAH-2-em3 #Ping a puerta de enlace,gw1,gw2,gw3,gw4 ping_group red_local 10.255.255.12 respawn hacluster /usr/lib/heartbeat/ipfail apiauth ipfail gid=haclient uid=hacluster node vivaitcall-CL-UAH-1 node vivaitcall-CL-UAH-2

- Nota: El parámetro auto_failback se utiliza para indicar si queremos que al recuperarse una maquina adquiera los recursos sobre los que tiene prioridad.

- El segundo fichero es authkeys,, este fichero es el mismo en ambas maquinas:

chmod 600 authkeys (importante) auth 1 1 sha1 claveSecretaATope

- El tercer fichero haresources, donde especificaremos en las dos maquinas que deben apuntar a la maquina que queremos que tenga prioridad en la adquisición de los recursos, este fichero es el mismo en las dos maquinas:

MÁQUINA 1 -> vivaitcall-CL-palacio-1 hb_mdtel MÁQUINA 2-> vivaitcall-CL-palacio-1 hb_mdtel

- Copiaremos en el directorio /etc/ha.d/resource.d/ los scripts de arranque con permisos 755 (lo podemos hacer mediante WINSCP). Los scripts se encuentran en C:\Documents and Settings\javier.gutierrez.MDTEL\Mis documentos\Centrales\Asterisk\Cluster\scripts.

chmod 755 hb_catalina chmod 755 hb_mdtel chmod 755 hb_mdtel_firewall

- Deberemos editar el archivo hb_mdtel

(IP flotante a.b.c.d./mask) 10.255.255.10 CAD_IP_FLOTA=10.255.255.10/24/bond0

- Paramos el proceso myAcdSuperv.

mv /etc/rc2.d/S02myAcdSuperv s02myAcdSuperv

- Reiniciamos ambas maquinas para que su kernel tome los cambios.

3.2.3 Comprobación de buen funcionamiento del cluster

- La maquina activa tiene que tener en HDcluster montado el disco con todos sus directorios y la maquina inactiva no (tenemos que ver el archivo que hemos creado "sinMontar").

- La ip virtual tiene que estar en la maquina activa (ifconfig) y no tiene que estar en la inactiva.

- El asterisk tiene que estar arrancado en la maquina activa y parado en la inactiva.

- Tecleando la ip de la maquina activa en un navegador debemos acceder al portal de vivait-call y en la inactiva no debe de estar activo.

- Para cambiar el cluster manualmente podemos utilizar los siguientes comandos:

/usr/share/heartbeat/hb_takeover

- La maquina desde la que se ejecuta se convierte en la maquina activa

/usr/share/heartbeat/hb_standby

- La maquina desde la que se ejecuta deja de ser la maquina activa

3.2.4 Notas para MySQL

Si mysql es parte del cluster tenemos que tener en cuenta dos cosas:

- El archivo /etc/mysql/debían.cnf contiene una clave que debe ser igual en ambas maquinas y debe ser la clave de la máquina de donde cojamos la base de datos.

# Automatically generated for Debian scripts. DO NOT TOUCH! [client] host = localhost user = debian-sys-maint password = AI6AdPtnhLUrNm1S socket = /var/run/mysqld/mysqld.sock [mysql_upgrade] user = debian-sys-maint password = AI6AdPtnhLUrNm1S socket = /var/run/mysqld/mysqld.sock basedir = /usr

- El archivo /etc/apparmor.d/usr.sbin.mysqld contiene donde pueden estar ubicados los archivos de mysql, al cambiar su ubicación y poner un enlace directo en /var/lib/mysql si no modificamos este archivo mysql no arrancara al no tener la nueva ubicación entre sus localizaciones permitidas. Este es un ejemplo de las líneas que debemos añadir.

/var/run/mysqld/mysqld.sock w, (copiar después de esta linea) #//!! /HDcluster/var/lib/mysql/ r, /HDcluster/var/lib/mysql/** rwk, #//!!

3.2.5 Notas de desincronización

EL servicio del DRBD esta iniciado pero al teclear el comando cat /proc/drbd para ver si esta sincronizando se presenta "primary/unknown" y/o secondary/unknown ".

- En el nodo primary

drbdadm connect all

- En el nodo secondary

drbdadm disconnect all drbdadm -- --discard-my-data connect all

3.2.6 Adaptar red a cliente

Para adaptar la red de los equipos al entorno del cliente hay que editar los siguientes ficheros:

/etc/network/interfaces /etc/resolv.conf /etc/hosts /etc/ha.d/resource.d/hb_mdtel /etc/ha.d/ha.cf - TFTP: /etc/inetd.conf (IP del cluster) |

Tras la modificaciones oportunas, se debe reiniciar las dos máquinas para cargar las nuevas configuraciones.

3.3 Matriz de conmutación

Encontramos dos diferentes núcleos de conmutación en la plataforma VIVAit:

- Para los nodos de procesamiento ACD el núcleo de conmutación es asterisk 1.4 RSP con fuertes modificaciones realizadas por MDtel en determinados módulos (queues, chan_spy entre otros)

- Para los nodos que realizan funcionalidad de gateway y/o procesamiento de telefonía corporativa, se utiliza como núcleo de conmutación asterisk 13, versión certified

https://wiki.asterisk.org/wiki/display/AST/Asterisk+13+Documentation

3.3.1 Dialplan

En función del nodo en el que estemos trabajando, encontraremos dos tipos de dialplan:

- Dialplan ACD --> Dialplan que aplica a nodos ACD

- Dialplan corporativa --> Dialplan que aplica a nodos de corporativa o gateways (ya sean de corporativa o ACD)

En la plataforma VIVAit, el dialplan es parte fundamental de la plataforma, no pudiendo ser modificado o sustituido de manera no planificada

3.4 Servicios networking

Son muy importantes las configuraciones adecuadas de los servicios de:

- NTP: El sistema en global ha de estar sincronizado; todos los servidores y puestos de trabajo (en el caso de VIVAit Suite) han de estar perfectamente sincronizados; los servidores de la plataforma se sincronizarán con el NTP del cliente; si el cliente no tiene NTP será necesario que un servidor de la plataforma se sincronice con un NTP externo y este sea el servidor para el resto de la plataforma

- DNS: La configuración de DNS de la plataforma será coherente con el resto de la plataforma IT del cliente

- DHCP: Es necesario coordinar con el cliente la asignación de direcciones para los diferentes elementos de la plataforma VIVAit, fundamentalmente para terminales telefónicos; en este caso además será necesario activa la opción 66 que permitirá definir el servidor TFTP del que los terminales cogerán sus ficheros de aprovisionamiento

3.5 Bases de datos (BBDD)

La base de datos del sistema se basa en el motor de base de datos MySQL, es un elemento crítico del sistema, en el que insertan y del que obtiene mucha información múltiples procesos. Muchas comunicaciones entre procesos se realizan vía Base de Datos (tabla COM_COMUNICADOS). Pueden existir distintas instancias de base de datos que explicadas en las siguientes secciones, nuestra base de datos tiene la siguiente estructura: Información completa de la BD. Podéis ampliar más información en https://dev.mysql.com/doc/

3.5.1 BBDD Tiempo Real

En la base de datos de tiempo real insertan información todos los procesos del sistema, y se realizan los cambios en configuración utilizando como herramienta el portal de administración y VIVAit Supervisor

De la base de datos de tiempo real leen los procesos que requieren información, y las aplicaciones:

- VIVAit Supervisor (para reporting de tiempo real)

- PanelWeb

- Datos de sesión de VIVAit Desk

- Monitorización Zabbix

- Otros

El portal de administración se encarga de escribir las configuraciones añadidas o modificadas en la base de datos

3.5.2 BBDD Réplica

A efectos de asegurar las prestaciones del sistema, se establece una réplica de la base de datos, sincronizada con la de tiempo real; los procesos y aplicaciones pesados, que realicen consultas a las base de datos que puedan comprometer las prestaciones del sistema atacan a la réplica y nunca a la base de datos de tiempo real

Es posible que en instalaciones pequeñas no exista réplica, en cuyo caso se establece una base de datos unificada sobre la de tiempo real, en la que se añaden índices y procedimientos almacenados que típicamente residen en la de réplica.

Es posible establecer tantas réplicas como sean necesarias si diferentes procesos pesados se penalizan en exceso, si bien una implantación tipo contemplará una sola

Algunos procesos que utilizan la base de datos de réplica son:

- VIVAit Reporting

- VIVAit Tracker

- Histórico en tiempo real de VIVAit Supervisor

IMPORTANTE: Ningún proceso, programa, aplicación, etc. escribe en la base de datos de réplica; tan solo se extrae información

3.5.3 BBDD de copia

A efectos de asegurar el funcionamiento y como medida de contingencia ante un problema puntual de comunicación con la BD de tiempo real, en cada nodo disponemos de una BD de copia local. Posiblemente de un tamaño menor que la BD de tiempo real, dependiendo de cuanto tiempo pase hasta la próxima sincronización con la base de tiempo real.Esta base de datos llamada nimitzCopia.

Solo entrara en funcionamiento,cuando se produzca el problema mencionado, dejando acceder a los datos y poder dar servicio a la empresa mientras se soluciona el problema.

3.5.3.1 Backup y restore

Se utilizan dos script, para realizar la copia de seguridad y restaurar en la base de datos de copia local que son:

- El proceso bdCentral.sh que es el encargado de realizar la copia de seguridad. Tiene un archivo de configuración bdCentral.conf. En este archivo hay un parámetro (IGNORE_TABLAS) que indica las tablas de las que NO se realizará copia de seguridad. Toda tabla que no se indique formará parte de la copia de seguridad. Vuelca los resultados en /var/log/bdCentral.log

- El proceso bdNodo.sh que es el encargado de descargar la copia de seguridad y restaurarla en local. Tiene un archivo de configuración bdNodo.conf. Vuelca los resultados en /var/log/bdNodo.log. El fichero de backup se copia mediante el usuario sincroniza, que deberá poder acceder sin contraseña al servidor donde reside la copia.

En caso de producirse algún error en alguno de los procesos, marcarán dicho error en el log con una línea que comienza con la cadena "*ERROR".

3.5.4 Diagnósticos y operaciones sobre bases de datos

Comandos importantes, desde dentro consola de Mysql:

show master status: Realizado desde el master show slave status: Realizado desde el esclavo; el valor "seconds behind master" nos indica cuanto está retrasada la réplica con respecto a la base de datos de tiempo real

3.6 Procesos propios

3.6.1 bdCentral

El proceso bdCentral.sh es el encargado de realizar la copia de seguridad. Tiene un archivo de configuración bdCentral.conf. En este archivo hay un parámetro (IGNORE_TABLAS) que indica las tablas de las que NO se realizará copia de seguridad. Toda tabla que no se indique formará parte de la copia de seguridad. Vuelca los resultados en /var/log/bdCentral.log

En caso de producirse algún error, se marcará dicho error en el log con una línea que comienza con la cadena "*ERROR".

Para ejecutar bdCentral:

bdCentral.sh /etc/MDtel/bdCentral.conf

Estos procesos se ejecutan automáticamente. Para ello está copiado el fichero bdCentral a /etc/cron.d.

Por defecto la programación vienen comentada por lo que será necesario activarlo.

Para que se roten los logs hay que copiar el fichero bdCentral.logrotate a /etc/logrotate.d (como bdCentral)

3.6.2 bdNodo

El proceso bdNodo.sh es el encargado de descargar la copia de seguridad y restaurarla en local. Tiene un archivo de configuración bdNodo.conf. Vuelca los resultados en /var/log/bdNodo.log. El fichero de backup se copia mediante el usuario sincroniza, que deberá poder acceder sin contraseña al servidor donde reside la copia.

En caso de producirse algún error, se marcará dicho error en el log con una línea que comienza con la cadena "*ERROR".

Para ejecutar bdNodo:

bdNodo.sh /etc/MDtel/bdNodo.conf

Estos procesos se ejecutan automáticamente. Para ello está copiado el fichero bdNodo a /etc/cron.d.

Por defecto la programación vienen comentada por lo que será necesario activarlo.

Para que se roten los logs hay que copiar el fichero bdNodo.logrotate a /etc/logrotate.d (como bdNodo)

3.6.3 Intz-Nimitz

Permite integrar procesos de asterisk (del dialplan) con la base de datos; por ejemplo es el que graba segmentos, inspecciona donde esta registrado un agente…etc. La estabilidad de este proceso es importante para el funcionamiento del sistema, si bien las llamadas entran en caso de no estar disponible.

Para mas información consultar la página de intz-nimitz.

Desde un SSH ejecuta el comando “nc ip_maquina 1115”

root@vivait-acd:~# nc localhost 1115 intz-nimitz sis ver='V02.6' inic='20140401 110116' alarmas=21 ultAlar='20140414 171244' intz-nimitz gmp msj=942/1024 buf=1024/1024 tarea=16/102 intz-nimitz tmp uptime=1816550 (21d 0h 35m 50s) intz-nimitz vic identif='cms1' entorno='nimitz' conx=0/128 numConx=1018(0) intz-nimitz mys curro=80/0/0/0 soli=1012(0) soliErr=6(0) soliEncol=0(0/0) intz-nimitz cache colas=128/10/0/0 vdn=128/8/0/0 usuExten=10/0/0/0

Donde cada parámetro monitorizado indica:

| Parámetro | Descripción |

|---|---|

| sis/ver | Versión del proceso |

| sis/inic | Fecha de de arranque del proceso |

| Sis/alarmas | Alarmas desde arranque |

| Sis/ultAlar | Fecha de última alarma |

| Gmp/msj | |

| Gmp/buf | |

| Gmp/tarea | |

| Tmp/uptime | Tiempo que lleva el servicio activo |

| Vic/identif | Etiqueta de identificación del servicio |

| Vic/entorno | Entorno de base de datos |

| Vic/conx | Conexiones activas/conexiones máximas |

| Vic/numConx | Conexiones totales (último minuto) |

| Mys/curro | |

| Mys/soli | Conexiones solicitadas (último minuto) |

| Mys/soliErr | Conexiones solicitadas con error (último minuto) |

| Mys/soliEncol | Conexiones encoladas |

| Cache/cola | Colas monitorizadas/ |

| Cache/vdn | VDN’s monitorizados |

| Cache/usuExten |

3.6.4 motorSal

Parte fundamental del proceso de marcación saliente, gestiona como hay que llamar a los diferentes contactos asignados a las campañas. Transforma los contactos en intentos de marcación.

A efectos de diagnósticos, desde un SSH ejecuta el comando “nc ip_maquina 1120”

root@vivait-acd:~# nc localhost 1120 motorSal sis ver='V01.4' inic='20140725 140832' alarmas=1 ultAlar='20140725 140832' motorSal gmp msj=253/256 buf=256/256 tarea=99/102 motorSal tmp uptime=600165 (6d 22h 42m 45s) motorSal mtr mys=1 ocup=0% planif=28(0) intento=26(0)

Donde cada parámetro monitorizado indica:

| Parámetro | Descripción |

|---|---|

| SIS/ver | Versión del proceso |

| SIS/inic | Fecha de de arranque del proceso |

| SIS/alarmas | Alarmas desde arranque |

| SIS/ultAlar | Fecha de última alarma |

| Gmp/msj | |

| Gmp/buf | |

| Gmp/tarea | |

| Tmp/uptime | Tiempo que lleva corriendo |

| mtr/mys | Si está conectado al MySQL |

| mtr/ocup | Porcentaje de ocupación |

| mtr/planif | Contactos planificados Totales (Último minuto) |

| mtr/intento | Intentos totales (Ültimo minuto) |

Respecto a los logs del motroSal consultar el siguiente apartado: Trazas motorSal

3.6.5 MyACDSuperv

Refleja el estado de las colas de asterisk en la base de datos; tiene sentido a efectos de estadísticas e informes, pero no a efectos de funcionamiento de la conmutación de voz

Es también el proceso que genera las llamadas en el marcador automático de VIVAit Suite

A efectos de diagnósticos, desde un SSH se ejecuta el comando “nc ip_maquina 1112”

root@vivait-acd:~# nc localhost 1112 myAcdSuperv SIS ver='04.6' inic='20140416 081613' alarmas=6 ultAlar='20140416 121652' myAcdSuperv AMI cnx=1 ocup=28% exten=2/2/511 asig=0/11/4095 myAcdSuperv MYSQL cnx=1 ms=316

Donde cada parámetro monitorizado indica:

| Parámetro | Descripción |

|---|---|

| SIS/ver | Versión del proceso |

| SIS/inic | Fecha de de arranque del proceso |

| SIS/alarmas | Alarmas desde arranque |

| SIS/ultAlar | Fecha de última alarma |

| AMI/cnx | Conectado (1) a asterisk |

| AMI/ocup | Porcentaje de ocupación de MyACDSuperv |

| AMI/exten | - |

| AMI/asig | |

| MYSQL/cnx | Conectado (1) a MySQL |

| MYSQL/ms | Tiempo de última operación en ejecutarse |

3.6.6 proceso escoba

El proceso escoba se encarga de resolver y consolidar todos aquellos segmentos de grabación que han quedado almacenados en los gateways por falta de información o incoherencias. Existen dos tipos de procesos escobas:

- Proceso escoba perteneciente a nodo con agente de grabación (recordNodo) llamado escobaGW.pl.

- Proceso escoba perteneciente o no a un servidor de grabación (recordCentral) llamado escobaGrabsBd.pl.

3.6.6.1 escobaGW.pl

Proceso que se ejecuta en los nodos busca en el disco RAM , las grabaciones de segmentos cuya antigüedad sea superior a mas de un día, es decir, si el proceso por ejemplo se ejecuta a la 01:00 a.m. del día 24/03/2016 buscara todas aquellas grabacionesn de segmentos realizadas antes de la 01:00 a.m del día 22/03/2016. Una vez realizada la busqueda, obtendra el UCID a traves del nombre del fichero, y comprobara su correspondencia con la tabla DAT_LLAMADAS. Si existe una llamada con ese UCID, cambiara el estado de la llamada para que sea procesada correctamente. En caso contrario, es movida a la carpeta /var/lib/recordNodo/grabError.

3.6.6.2 escobaGrabsBd.pl

Se ejecuta sobre la base de datos de histórico, normalmente se ejecuta en un servidor de grabación (recordCentral). El proceso hace una búsqueda en dos tablas:

- En DAT_SEGMENTOS obtiene todos aquellos segmentos con grabaciones que dieron error, su estado tendrá valor 120.

- En DAT_LLAMADAS obtendremos todos los registros correspondiente al segmentos anteriores.

Después hace una búsqueda en el sistema, usando como ruta el campo D_HORA_INICIO de cada llamada, que indica la ruta entera donde se encuentra el archivo. Una vez encontrado el archivo cambia el estado del segmento que tenia un error a estado de grabación disponible , que tendrá valor 100. Si no encontramos el segmento, no realizara nada.

3.6.7 recordCentral

Se considera como un servidor de grabaciones. Todas las grabaciones de llamadas son un activo importante y una empresa con Contact Center pueda recibir millones de llamadas que necesitan estar registradas y almacenadas en discos duros con gran capacidad, dichas maquinas donde suelen alojarse estos servidores poseen discos duros limitados, lo que hace necesario en algunos casos incorporar dispositivos NAS.

Los dispositivos NAS son dispositivos de almacenamiento conectados a una red que permite el almacenamiento y la recuperación de datos desde una ubicación centralizada, flexibles y escalables, lo que significa que a medida que necesite almacenamiento adicional, puede añadirlo al que tiene. Esto no indica que sea necesario poseer de dispositivos NAS para funcionar, sino que puede tomar datos de diferentes sitios.

En recordCentral pueden existir tres tipos de dispositivos NAS:

- Uno dedicado para las llamadas

- Uno dedicado para los segmentos

- Uno mixto para todas las llamadas y segmentos.

El recordCentral se encarga de recoger todas las grabaciones de segmentos que tienen de estado proceso(3) en cada nodo gestionado, es decir, coger aquellos segmentos de llamadas marcados como llamadas disponibles, intenta descargar los segmentos de las llamadas y convertirlas al formato adecuado (MP3).

Como una característica particular cada diez minutos, siempre que no tenga ninguna otra tarea, intenta ver si puede establecer conexión con un nodo en cuarentena, para sacarlos de cuarentena y recoger todas las grabaciones de segmentos disponibles, para intentar convertir y descargar todas las grabaciones.

A efectos de diagnósticos, desde un SSH se ejecuta el comando nc ip_maquina 1114 en la maquina donde creamos que debe estar ejecutando el proceso recordCentral. Ejemplo:

root@smadavacdrecord1:~# nc localhost 1114 recordCentral SIS ver='01.2' inic='20140423 094058' alarmas=11041 ultAlar='20140423 160112' recordCentral MYSQL cnx=1 recordCentral NAS llamadas=1 segmentos=1 recordCentral REC llamNum=24901 llamErr=0 segmNum=38906 segmErr=0 retraso=305 recordCentral NODO fase=0 cuarentena= descarga='8,6,4,7,10,9' gestion='4,6,7,8,9,10'

La explicación de los campos se muestra en la tabla siguiente:

| Parámetro | Descripción |

|---|---|

| SIS/ver | Versión del proceso |

| SIS/inic | Fecha de de arranque del proceso |

| SIS/alarmas | Alarmas desde arranque |

| SIS/ultAlar | Fecha de última alarma |

| MYSQL/cnx | Conectado (1) a MySQL |

| NAS/llamadas | Alojamiento en NAS de llamadas activo (grabación de llamada completa en un único archivo) |

| NAS/segmentos | Alojamiento en NAS de segmentos activo |

| REC/llamNum | Llamadas procesadas |

| REC/llamErr | Llamadas con error |

| REC/segmNum | Segmentos procesados |

| REC/segmErr | Segmentos con error |

| NODO/fase | Número de proceso de recordCentral |

| NODO/cuarentena | Lista de nodos en cuarentena, separada por comas |

| NODO/descarga | Lista de nodos en descarga, separada por comas |

| NODO/gestion | Lista de nodos gestionados, separada por comas (cuarentena + descarga = gestión) |

3.6.8 recordNodo

Se considera como proceso con función de agente de grabación para un nodo. Solo debe existir uno por maquina o por nodo (configurado como grabador) en el portal de administración de VIVAit.

Para su funcionamiento utiliza un disco RAM por que su tiempo de acceso mejora drásticamente, debido a que la memoria RAM es varios órdenes de magnitud más rápida que las unidades de disco reales, haciendo que la velocidad de procesamiento de las grabaciones sea mucho mas rápida.

Este disco RAM normalmente ocupa la mitad de la memoria RAM de una maquina pero no es obligatorio pues dependerá de la memoria disponible en cada maquina, y además, se configura con un tamaño no superior a 2GB de memoria RAM. Hay que tener especial cuidado en que no se llene en espacio ni tampoco los i-nodos. Se puede monitorizar a través de la aplicación zabbix.

El recordNodo se encarga de recoger todas las grabaciones de segmentos que tienen de estado proceso(2), es decir, aquellos segmentos de llamadas que han sido grabadas pero no están siendo procesadas, moviéndolas del disco RAM a su carpeta correspondiente.

La forma de obtener la carpeta correspondiente es obteniendo el dato del campo D_HORA_INICIO en la tabla DAT_LLAMADAS para cada segmento,tras un tratamiento del campo creara la subruta correspondientes: /año/mes/dia/hora/min. Entonces, la ruta correcta seria /var/lib/recordNodo/grabaciones/año/mes/dia/hora/min, donde año, mes, dia , hora y min son los valores numéricos obtenidos del campo D_HORA_INICIO.

A efectos de diagnósticos, desde un SSH se ejecuta el comando nc ip_maquina 1113 en la maquina donde creamos que debe estar ejecutando el proceso recordNodo:

root@smadavgw5:~#nc localhost 1113 recordNodo SIS ver='04.00.00' inic='20160326 105137' alarmas=2 ultAlar='20160326 105542' recordNodo MYSQL cnx=1 recordNodo REC grabNum=0 grabErr=0

La explicación de los campos se muestra en la tabla siguiente:

| Parámetro | Descripción |

|---|---|

| SIS/ver | Versión del proceso |

| SIS/inic | Fecha de de arranque del proceso |

| SIS/amarmas | Alarmas desde arranque |

| SIS/ultAlar | Fecha de última alarma |

| MYSQL/cnx | Conectado (1) a MySQL |

| REC/llamNum | Llamadas procesadas |

| REC/llamErr | Llamadas con error |

| REC/segmNum | Segmentos procesados |

| REC/segmErr | Segmentos con error |

3.6.9 Vivait-CTI

Permite la comunicación entre la aplicación VIVAit Desk de agente y el asterisk, sincronizando; convierte el protocolo “asterisk manager” a CSTA (VIVAit Desk “habla” CSTA).

Es un proceso importante para que el uso de VIVAit Desk, y que los agentes puedan realizar su operativa normal con la entrada y salida de llamadas… si bien el cursado telefónico de llamadas es factible, no disponer de las facilidades de VIVAit Desk y formularios hace el sistema difícilmente manejable

A efectos de diagnósticos, desde un SSH se ejecuta el comando “nc ip_maquina 1111”

root@vivait-acd:~# nc localhost 1111 vivait-cti sis ver='V01.5' inic='20140414 104312' alarmas=13 ultAlar='20140415 173152' vivait-cti gmp msj=1018/1024 buf=1023/1024 tarea=97/102 vivait-cti tmp uptime=694748 (8d 0h 59m 8s) vivait-cti cti numConx=(0/511) numPend=(0/127) numMakeCallPend=0 numCall=(0/2047) numChan=(0/4095) numAuxStr=(0/511) numMoniColas=(0/511) numMoniDevice=0 numMoniCall=0 numMoniCallAuto=0 numMoniCallByDevice=0 numMoni=(0/511) auditCallErr=0 auditAuxStrErr=0 auditMsjReqErr=0 araChanID=0 araUniqueID=0 araMoni=0 vivait-cti ami esta=conx resp=652(0) evs=1397(0) descar=556(0) err=16 errConx=16 numAct(0/0/127) auditErrAct=0

Donde cada parámetro monitorizado indica:

| ver | Versión del proceso |

|---|---|

| sis/inic | Fecha de de arranque del proceso |

| Sis/alarmas | Alarmas desde arranque |

| Sis/ultAlar | Fecha de última alarma |

| Gmp/msj | |

| Gmp/buf | |

| Gmp/tarea | |

| Tmp/uptime | |

| Cti/numConx | Número de conexiones actuales / Número de conexiones máximo |

| Cti/numPend | |

| Cti/numMakeCallPend | Llamadas pendientes de realizar |

| Cti/numcall | |

| Cti/numChan | |

| Cti/numAuxStr | |

| Cti/numMoniColas | Número de colas monitorizadas |

| Cti/numMoniDevice | |

| Cti/numMoniCall | |

| Cti/numMoniCallAuto | |

| Cti/numMoniCallByDevice | |

| Cti/numMoni | |

| Cti/auditCallErr | |

| Cti/auditAuxStrErr | |

| Cti/ auditMsjReqErr | |

| Cti/ araChanID | |

| Cti/ araUniqueID | |

| Cti/ araMoni | |

| Ami/esta | Estado de conexión contra manarger de asterisk |

| Ami/resp | |

| Ami/evs | Número de eventos (último minuto) |

| Ami/descar | |

| Ami/err | Errores |

| Ami/errConx | Errores de conexión |

| Ami/numAct | |

| Ami/auditErrAct |

3.6.10 Phoneprov-TFTP

3.6.11 Introducción al aprovisionamiento

En cada Centralita Telefónica existente, se puede configurar sus teléfonos IP y asignarles extensiones a cada teléfono. Para hacer un aprovisionamiento de los teléfonos es necesario que el técnico configure uno a uno manualmente utilizando su interfaz web, esto no es práctico, ya que genera muchos errores y el tiempo de implementación se incrementa drásticamente. Además, es casi imposible la administración cotidiana de los teléfonos IP. Desde MDtel se utiliza una herramienta que permite que los teléfonos IP soportados y homologados por MDtel ([ver Terminales telefónicos]) se puedan aprovisionar automáticamente, brindando una fácil implementación y administración cotidiana.

3.6.11.1 ¿Qué es aprovisionar?

Aprovisionar un teléfono es el proceso de configuración automático de teléfonos IP para su uso con una Centralita Telefónica de forma remota. Una vez que aprovisione un teléfono, el teléfono automáticamente se configurará correctamente y podrá administrar los teléfonos de forma centralizada y remota, sin tener que iniciar sesión en la interfaz web de cada uno de los teléfonos.

El aprovisionamiento de teléfono facilita enormemente la administración cotidiana de los teléfonos IP. Esto hace que sea fácil de cambiar las contraseñas de extensión,realizar desvíos de llamadas, nombre a mostrar, mensajería y demás configuraciones, ya que puede hacerlo de forma centralizada para todos los teléfonos desde el portal de administración y luego transferir los cambios al teléfono.

3.6.11.2 TFTP

TFTP son las siglas de Trivial File Transfer Protocol (Protocolo de transferencia de archivos trivial).

Es un protocolo de transferencia muy simple semejante a una versión básica de FTP. TFTP a menudo se utiliza para transferir pequeños archivos entre terminales en una red.

Algunos detalles del TFTP:

- Utiliza UDP (puerto 69) como protocolo de transporte (a diferencia de FTP que utiliza los

puertos 20 y 21 TCP).

- No puede listar el contenido de los directorios.

- No existen mecanismos de autenticación o cifrado.

- Se utiliza para leer o escribir archivos de un servidor remoto.

- Soporta tres modos diferentes de transferencia, "netascii", "octet" y "mail”.

3.6.11.3 Funcionamiento del servidor phoneprove-TFTP

A continuación se muestra un esquema que facilita el entendimiento del funcionamiento del servidor phoneprove-TFTP:

El servidor Phoneprove-TFTP se encarga del aprovisionamiento masivo de terminales, es de gran utilidad porque cualquier cambio en los teléfonos pueden ser realizados a nivel DHCP y todos los teléfonos tomarán la nueva configuración luego de reiniciarlos.

Desde phoneprove-TFTP se generara los archivos necesarios para cada teléfono y que sirven para ser aprovisionados automáticamente. El servidor phoneprove-TFTP tiene alojados los ficheros de configuración están ordenados según las direcciones MAC de los teléfonos. El teléfono “preguntará” al servidor cual es su fichero de configuración utilizando su dirección MAC. Este a través de su MAC , consulta en la base de datos para ofrecer al terminal los datos de configuración según su plantilla, cual sera su extensión , cual sera el usuario propietario, entre otras cosas.

Nota: En instalaciones grandes habrá más de uno, quizás uno por sede grande; depende de la infraestructura de DHCP. |

3.6.11.4 Parámetros necesarios de Aprovisionamiento de Teléfonos

Notas: el aprovisionamiento desarrollador por MDtel, no emplea un fichero por cada teléfono, sino que emplea una plantilla por cada modelo de teléfono. Debe haber una configuración previa del servidor DHCP es necesario coordinar con el cliente la asignación de direcciones para los diferentes elementos de la plataforma VIVAit, fundamentalmente para terminales telefónicos; en este caso además será necesario activa la opción 66 que permitirá definir el servidor TFTP del que los terminales cogerán sus ficheros de aprovisionamiento. El aprovisionamiento desde el portal de administración solo es posible para aquellos teléfonos IP homologados y probados desde MDtel [ver Terminales telefónicos]

Como existen parámetros comunes de todos los teléfonos de la misma marca de fabricante, muchos de los parámetros necesarios para el aprovisionamiento como comentamos se han generado desde MDtel en forma de plantillas, que estarán disponibles en el portal de administración VIVAit [| ver plantilla del portal de administración VIVAit].

La configuración de un teléfono SIP es muy sencilla y en no es necesario tener conocimientos avanzados de informática o de telefonía. Cada una de estas plantillas que sirven para aprovisionar un teléfono IP homologado, algunos de los parámetros predeterminados se explicarán a continuación .

3.6.11.4.1 Parámetros de Aprovisionamiento globales

- Configuración de la red y MAC.

- Zona horaria.

3.6.11.4.2 Parámetros de Aprovisionamiento Personales

Además de los parámetros de aprovisionamiento globales, el teléfono también obtendrá información de configuración individual, tales como:

- Número de Extensión.

- Nombre y Contraseña de usuario SIP.

- Configuración de Teclas BLF.

- Contraseña de la Interfaz Web del Teléfono IP.

- Idioma de la Pantalla.

- Orden de Preferencia de los Codecs.

3.6.11.5 Aprovisionamiento de teléfonos nivel usuario

Notas: La dirección MAC debe estar especificada en letras mayúsculas. La dirección MAC del teléfono se puede encontrar en la etiqueta adhesiva en la parte inferior del teléfono, o de lo contrario se deberá acceder desde el menú del propio terminal. |

Los pasos a seguir son los siguientes:

1) Dar de alta el teléfono en el portal de administración, se debe seleccionar el modelo del teléfono, e indicar la dirección MAC del teléfono a aprovisionar, todo ello desde el portal de administración VIVAit. Para mas información ver [del portal de administracion| aprovisionamiento del portal de administración VIVAit].

2) En el mismo portal de administración se deberá crear una extensión , asignar a la extensión el teléfono que se quiera aprovisionar, elegir la plantilla adecuada del teléfono y el usuario propietario (solo si sera un puesto fijo) desde [| extensiones del portal de administración].

3) Conectar el teléfono a la red LAN informática (conectarlo al router o switch) para que tenga acceso a Internet:

- El teléfono enviará un mensaje de multidifusión a través de la LAN.

- Este será captado por la Central Telefónica siempre que esté en la misma LAN.

- Al teléfono se le enviará una URL de aprovisionamiento.

4) Como la mayoría de teléfonos IP del mercado al arrancar una vez sabiendo la URL de aprovisionamiento piden una serie de archivos de configuración para aprovisionarse vía TFTP. EL servidor phoneprove-TFTP, detectara la petición y a través de la MAC y datos del usuario, consultará en la base de datos los datos necesarios para aprovisionar al teléfono y si todo funciona correctamente mandara al teléfono IP los datos de configuración necesarios para funcionar.

5) Asegúrese de que el teléfono encuentren el servidor TFTP, para ello esperar un tiempo adecuado para que termine el aprovisionamiento. 6) Finalmente aparecerá como registrado en la centralita, obtendrá una dirección IP y podra funcionar según la configuración establecida.

Nota: Si no se reaprovisiona tras un periodo largo de tiempo, desenchufe el cable de alimentación eléctrica o el cable Ethernet (si se utiliza la alimentación en línea PoE) para reiniciar los teléfonos. |

3.6.11.6 Aprovisionamiento de teléfonos nivel técnico

3.6.11.6.1 Plantilla de configuración

La plantilla de configuración empleadas en el apartado [| plantilla del portal de administración VIVAit] de cada modelo está formada por una serie de variables.

Los valores se obtienen de la tabla de la base de datos CEN_TELEFONOS, CEN_USUARIOS, ACD_EXTENSIONES, ACD_NODOS, COM_NODOS... correspondientes a la extensión del teléfono, usuario, nodo, etc.

variable ${NODO1_C_NOMBRE}='corp-ast13'

variable ${EXTEN_C_CLAVE_REGISTRO}='Tel21002'

variable ${USU_C_CODIGO_POSTAL}=28034'

variable ${SEDE_C_CODIGO_POSTAL}='28034'

variable ${USU_C_NOMBRE}='Juan Antonio'

variable ${USU_C_APELLIDO2}='Ramirez'

variable ${SEDE_C_NOMBRE}='RED_LAB'

variable ${NODO2_C_NOMBRE}= NULL

variable ${EXTEN_C_NOMBRE}= 21002

variable ${USU_C_LOCALIDAD}=

variable ${USU_C_NOMBRE_MOSTRAR}='Juan'

variable ${NODO1_C_IP}='175.25.129.70'

variable ${MODEL_C_PREFIJO_PLANTILLA_MAC}='T28P'

variable ${SEDE_C_LOCALIDAD}='Madrid'

variable ${USU_C_APELLIDO1}='Casas'

variable ${NODO2_C_IP}= NULL

variable ${TF_ID_EXTENSION}='5'

cargando campos idExten=5

3.6.11.6.2 Ficheros y paquetes necesarios

Paquetes previos: libnet-tftpd-perl, tftp-hpa, libnet-address-ip-local-perl Usuario de funcionamiento: root

Nota: los archivos y directorios que generemos podrian necesitar que se permitiera el acceso al archivo de lectura y escritura en el servidor TFTP. |

Archivos necesarios:

/usr/local/sbin/phoneprov-tftp.pl /etc/MDtel/phoneprov-tftp.pconf /etc/init/phoneprov-tftp.conf /etc/logrotate.d/phoneprov-tftp |

Directorios a crear:

/var/lib/phoneprov-tftp/plt /var/lib/phoneprov-tftp/bin }

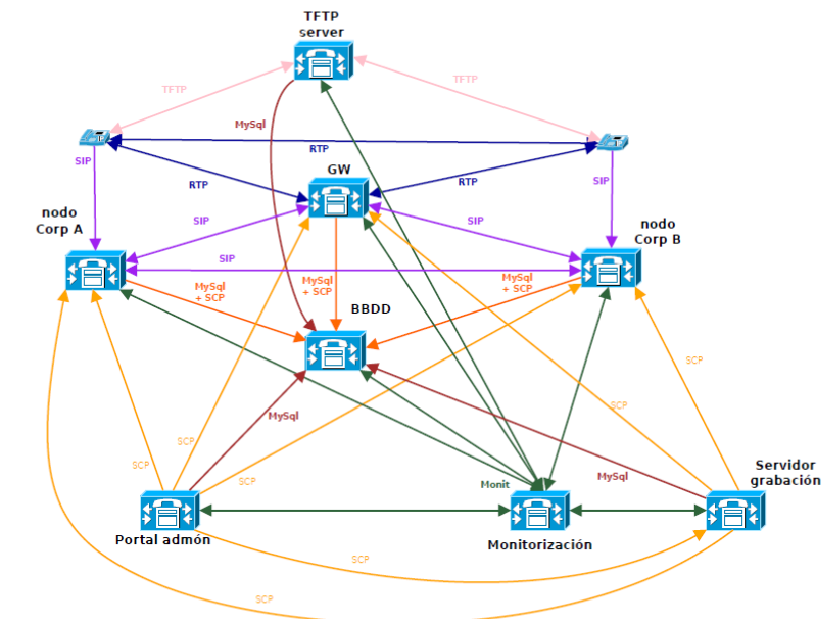

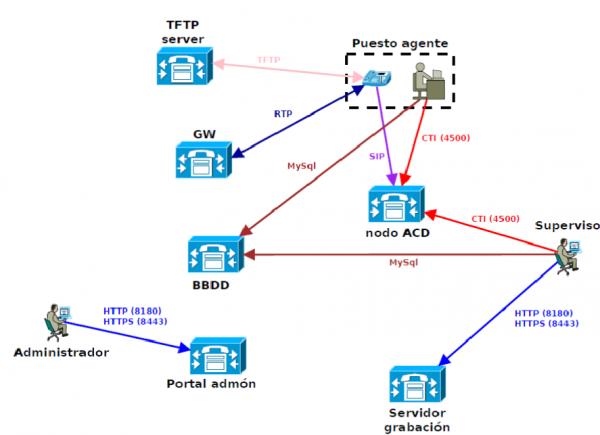

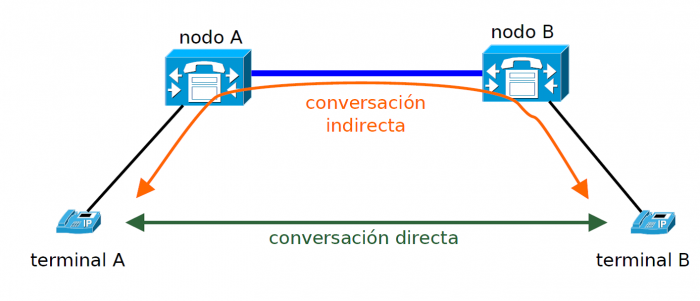

3.7 Requerimientos de conectividadEl esquema siguiente muestra como ejemplo todos los flujos de información existentes en un entorno típico de telefonía corporativa (sin presencia) (VIVAit Call) En el entorno de Contact Center, encontramos los siguientes flujos entre servicios (comunicaciones entre servidores, (VIVAit Suite)) y entre usuarios y servicios los reflejados a continuación:

3.8 GatewaysEl concepto de gateway como tal no existe en la plataforma VIVAit; existen nodos de ACD y nodos de corporativa. A efectos de operación un nodo de corporativa es el que en cualquier caso asumirá las funcionalidades de gateway, y recibirá las conexiones (analógicas, digitales o IP) a sistemas externos o a la RTC El concepto gateway queda pues suscrito a entornos meramente comerciales Incluimos no obstante en este apartado los diagnósticos y operaciones básicos de conexiones a sistemas externos o RTC 3.9 Servidor de grabación3.9.1 Almacenamiento en la nubeAlmacenamiento en la nube. Existe la posibilidad de que tras un determinado periodo de tiempo las grabaciones sean movidas a un almacenamiento externo. De esta operativa se encarga el proceso /usr/local/sbin/mueveGrabaciones.pl que recibe como parámetro la ruta al archivo de configuración. Dicho archivo tiene los siguientes elementos:

La grabación indica donde se encuentra mediante el campo E_UBICACION_GRABACION, que puede tener los siguientes valores:

3.10 ReportingLa aplicación de reporting en general no tiene procesos habituales de operación y mantenimiento. Los informes son obtenidos desde la interfaz gráfica o mediante un procedimiento de scripting, descritos en “Formato de fichero de intercambio para VIVAit Reporting”. 3.10.1 Formato de fichero de intercambio para VIVAit Reporting

“C:\Archivos de Programa\MDtel\Nimitz\LanzaInformes\LanzaInformes.exe” “C:\Archivos de Programa\MDtel\Nimitz\LanzaInformes\NIM00001.tmp” Ejemplo de fichero:

4 Otros Diagnósticos y operaciones básicas4.1 Arranque y apagado de la plataformaEn general el arranque y apagado de cada nodo de una plataforma VIVAit es el estándar de un procedimiento ordenado de apagado en una máquina linux: "Shutdown -h now" o comando de apagado inmediato o programado equivalente

4.2 Grabación4.2.1 Configuración de la grabación en la plataforma corporativaPara que una llamada se grabe, lo primero de todo es que alguien tenga la capacidad de grabar. Esto se consigue diciendo al nodo que sea grabador. Esto provoca que el nodo llame al mixmonitor para grabar y se inserte un registro en el DAT_GRABACIONES. Esto no significa que ya las llamadas se vayan a grabar, ya que para eso tiene que ser procesadas por un nodo que sea grabador. Hay tres, llamémosle elementos, que se pueden grabar:

Tenemos tres formas de grabar:

Si de los tres elementos tenemos que uno grabe, ya sea con o sin beep periódico, esa llamada se va a grabar ya que son OR, en cuanto haya un elemento que diga que grabe se va a grabar. Al igual pasa si tenemos que un elemento tenga descartar la grabación. La grabación no se inicia. Referente al campo de Modo de grabación en infraestructura, este no se emplea para la grabación de corporativo, sino que solo tiene validez en ACD. Para que exista una grabación a de existir un segmento asociado a esta. Los segmentos se tratan en las prerutas. Hay un campo es las prerutas que es Generar segmento al enrutar. Si está se generará el segmento del tipo de la preruta y su correspondiente grabación si esta está configurada. Si le decimos que no genere segmentos al enrutar y el sistema está configurado para que grabe, el recordCentral creará un tipo de segmento llamado externo para esa grabación. Podemos configurar si queremos que se cree o no ese segmento, para eso hay que modificar el fichero de configuración del recordCentral y poner un tiempo muy alto al campo $segmExternoMinSegs. También podemos configurar que segmentos queremos que se graben. Por defecto el recordCentral va configurado para que se graben todos los segmentos. Para decirle que solo grabe cierto tipo de segmentos hay que ponerlos los que queramos que si se graben en la variable $tiposSegmentoGrabar del fichero de configuración del recordCentral. 4.2.2 Comprobación de que el servidor de grabación esta activoSi al ejecutar el comando nc ip_maquina 1114, si no se recibe ninguna respuesta, significa el servidor de grabación no estaría activo. También usando el comando ps aux | grep recordCentral , donde si no escribe ningun resultado implica que tampoco esta activo. 4.2.3 Comprobación de que los nodos están conectados al servidor de grabaciónDebemos fijarnos en la linea de respuesta del comando nc ip_maquina 1114, que seria:

Sabiendo que el parámetro "fase=0" es el numero que identifica el recordCentral, los demás parámetros nos indicaran los nodos disponibles , que funcionan o no en el servidor. Entonces "gestión=4,6,7,8,9,10" indica el id de los nodos que maneja el proceso. 4.2.4 Comprobación de que un nodo tiene activo el agente de grabaciónSi al ejecutar el comando nc ip_maquina 1113, no se recibe ninguna respuesta, significa que el nodo no tiene activo el agente de grabación. También usando el comando ps aux | grep recordNodo, donde si no escribe ningun resultado implica que tampoco esta activo. 4.2.5 Comprobación de que un nodo está subiendo archivos de grabación al servidorDebemos fijarnos en la linea de respuesta del comando nc ip_maquina 1114, que seria:

Fijándonos en "descarga=8,6,4,7,10,9" nos confirma que todos los nodos que maneja el proceso funcionan perfectamente y el servidor puede manejar las grabaciones.

4.2.6 Comprobación de grabaciones que se hayan quedado enganchadas en un nodoPodemos fijarnos en los dos comandos, para nc ip_maquina 1114:

Fijándonos en el campo "cuarentena=" indica que ninguno de los nodos tiene problemas. 4.2.7 Comprobación del estado de ocupación del almacenamiento temporal de grabaciones en un nodo.Desde un SSH ejecuta el comando df - h en la maquina donde creamos que debe estar ejecutando el proceso recordNod:

Nos fijaríamos en la línea marcada en negrita, el campo "Use%" indicara el porcentaje de almacenamiento temporal de grabaciones en un nodo.

4.3 Escuchas e intrusiones en asteriskCallSpy es una aplicación elaborada para asterisk que permite a un usuario realizar escuchas e intrusiones en llamadas. En realidad tenemos dos aplicaciones en asterisk, CallSpy y CallSpyee. 4.3.1 CallSpy

Como hemos mencionado anteriormente, esta aplicación permite la escucha de llamadas y, opcionalmente, realiza la función de intrusión. Tiene tres opciones de configuración obligatorios que mostramos a continuación:

La opción <tipoEspiado> se refiere a que tipo de objeto que podemos espiar correspondiente, solo debe elegirse un único tipo:

La opción <expRegEspiado> representa el número de la cola, VDN, agente o extensión que queremos escuchar. Tiene que ser una expresión regular. La opción <parametrosConf> se refiera a los parámetros de configuración para la llamada que podemos espiar, se pueden combinar o juntar :

Una vez iniciada la escucha, solo falta que entre una llamada al objetivo que estemos espiando. Al iniciar la escucha, se puede hacer lo siguiente:

4.3.2 CallSpyee (espiado)Mediante esta aplicación indicamos los parámetros que permite a una llamada ser seleccionada para escuchar. Las opciones de configuración son:

La explicación de los parámetros es la siguiente:

Por ejemplo si queremos escuchar todas las llamadas en las que participa una extensión determinada pondremos en la macro de extensiones:

4.3.3 Cambios para el dialplan de asteriskEl funcionamiento de este tipo de servicio conlleva un cambio en el dialplan de asterisk. En cada macro correspondiente se pondrá los diferentes CallSpyee para VDN, colas , extensiones y agentes. Pasos a seguir:

extensión).

4.4 CalendariosEl servidor de calendarios reside en "/var/www/dav/html/cal.php" Para comprobar si el servidor interno de calendarios está operativo nos conectaremos al enlace http://IP_SERV_CALENDAR/dav/html/cal.php Si el sistema nos pide usuario y clave querrá decir que el servidor de calendarios está operativo en esa maquina Para comprobar que funciona en la consola de asterisk usaremos los comandos calendar show calendars calendar show calendar [nombreCalendario] Nota: Debido bugs detectados, el proceso requerirá:

- La realización de una sincronización manual de la sección "mdcal" desde el portal de administración

- Añadir la línea #include "/etc/asterisk/mdcal.conf" en el fichero calendars.conf y hacer "reload" de asterisk

4.5 Syslog de agentesSyslog es un estándar para el envío de mensajes de registro en una red informática IP. Por Syslog se conoce tanto al protocolo de red como a la aplicación o biblioteca que envía los mensajes de registro. Se lanza automáticamente al arrancar un sistema Unix, y es el encargado de guardar informes sobre el funcionamiento de la máquina (eventos, seguridad del sistema, etc) pero puede contener también cualquier información como mensajes de las diferentes partes del sistema (núcleo, programas...) y los envía y/o almacena en diferentes localizaciones transmitiéndose mediante un puerto UDP. Esto permite concentrar los registros de múltiples máquinas en un único punto simplificando la labor de gestión al administrador siendo habitual que múltiples dispositivos lo soporten. El formato del mensaje se compone de tres campos :

Si es necesario podemos activar el registro de todos los eventos telefónicos que realiza un agente ACD llamado Syslog de agentes. Su activación se realiza mediante el portal de administración VIVAit configurando unos parámetros para un usuario llamado Rastreo BBDD" y Rastreo Syslog. Para más información[| ver sección Portal de administración - General - Usuarios - Pestaña ACD ].

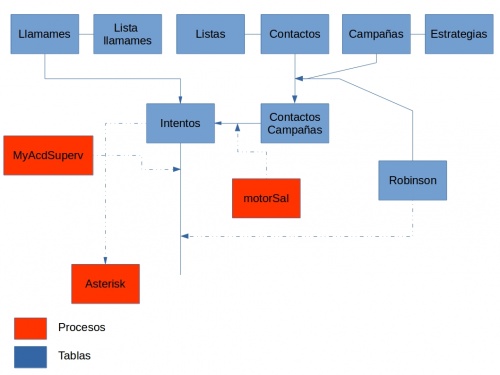

5 Funcionalidades específicas5.1 Mecanismo de prioridad adaptativaEl mecanismo de prioridad adaptativa permite en una plataforma VIVAit Suite establecer prioridades en las que se tenga en cuenta el tiempo de espera de las llamadas en cola, proporcionando una alternativa al mecanismo de prioridad absoluta que existe por defecto Se adjunta documento explicativo Asignación de llamadas por prioridad adaptativa 5.2 Marcación salienteDentro del ACD hay un comportamiento especial que es la marcación saliente. Esta puede ser de tres tipos:

5.2.1 Esquema de funcionamientoLos contactos se agrupan en listas para su facilidad de asignación a campañas, aunque finalmente lo que se asigna a una campaña es un contacto. Las campañas tienen estrategias. Las estrategias definen como se ha de llamar (del primero al último, sólo los pares, etc.). Tienen una serie de parámetros que dependiendo de la estrategia pueden tener distinta utilidad. Desde el punto de vista de la base de datos, las estrategias se definirían en la tabla ACD_CLASES_ESTRATEGIAS y se les da valor en la tabla ACD_ESTRATEGIAS_MARCADOR. Una vez establecida la campaña y asignados sus contactos y dependiendo del modo de marcación (que se define en las colas) el proceso motorSal crea los intentos de marcación (siempre y cuando no estén en las listas Robinson), que serán leídos por el proceso myAcdSuperv que los convierte en llamadas para el Asterisk. 5.2.2 Flujo de estadosEl flujo de estados es el reflejado en la figura siguiente Los diferentes estados de un contacto son:

5.2.3 Carga de contactosInstrucciones para carga automatizada de contactos Ejemplo de fichero de carga de contactos 5.3 MovilidadLa movilidad es una función integral de las comunicaciones en la empresa. Cualquier empleado (usuario) es móvil en cierto grado, sea dentro o fuera de la organización.La solución óptima debe proporcionar continuidad de servicios y acceso a nuestros servicios, sin importar donde se esté. 5.3.1 Ofrecer movilidad a un usuarioPara permitir la movilidad a un usuario, puede ser en el momento de crear o editar un usuario en el apartado Administración de usuario en General del portal de administración VIVAit. Asignándole un numero login (numero personal corporativo para el usuario) y una clave login ( se debe asignar una clave por defecto, pero puede cambiarla en el [|portal de usuario]). Para más información[| ver sección Portal de administración - General - Usuarios - administración de usuarios - Pestaña Centralita]. Además, de crear un permiso de la aplicación Centralita a cualquier nivel, desde el apartado Permisos de usuarios en General del portal de administración VIVAit.Para más información[| ver sección Portal de administración - General - Usuarios - Permisos a usuarios] Finalmente, y por razones de seguridad todo terminal tiene asociado una extensión y deberá permitir la movilidad de usuarios. La extensión se configura cambiando a SI el campo Hay Movilidad desde el apartado Extensiones de Dispositivos en VIVAit Call del portal de administración VIVAit. Para más información [| ver sección Portal de administración - VIVAit Call - Dispositivos - Extensiones] 5.4 GrabaciónLa grabación en VIVAit Call está diseñada para ser lo mas flexible posible. 5.4.1 ConfiguraciónSi deseamos grabar, debemos activar que alguno de los dispositivos/elementos que intervienen en la llamada se grabe. Estos dispositivos/elementos son:

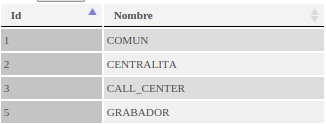

Por otro lado necesitaremos que la llamada pase por un nodo que sea grabador, es decir, que si la llamada esta configurada para que se grabe pero no pasa por ningún nodo grabador, la llamada no se grabará. Al configurar un nodo existen cuatro campos que intervienen en la grabación. 'Grabador' Se configura en el portal en la sección general/nodos. Este campo corresponde con el campo B_ES_GRABADOR de la tabla COM_NODOS , este campo define si el nodo va a grabar las llamas que pasen por el que necesiten ser grabadas y no se estén grabando ya. Es un campo booleano los posibles valores en el portal son si/no y en la base de datos 1/0.

Su configuración se realiza en el portal, en la sección general/nodos. Este campo define como está configurada la infraestructura, este campo existe por compatibilidad con VIVAit suite y para poder configurar la grabación bajo demanda. Este campo corresponde con el campo E_MODO_GRABACION_INFRAESTRUCTURA de la tabla COM_NODOS, Este campo usa los valores del enumerado BD.ENUM.TModoGrabacionInfraestructura|TModoGrabacionInfraestructura]]. La formula que se seguiría para ver si una llamada se graba en ese nodo es:

Que sería que si la infraestructura esta en NoGraba no se graba nada de lo que se rute en ese nodo y en cualquiera de los 2 otros caso (GrabaTodo o GrabaPorPeticion) se grabaría dependiendo de la configuración del Nodo, la ruta o el objeto en cuestión (preruta, grupo ACD, extension,...). 'Grabar enrutamiento' Se configura en el portal en la sección general/nodos. Este campo define si van a grabar las llamadas que se enruten en este nodo. Campo E_ENRU_GRABAR de la tabla COM_NODOS que usa los valores del enumerado TTipoEnruGrabar.

Se configura en el portal en la sección general/nodos. Define que instancia del recordCentral es la encargada de tratar las grabaciones de este nodo. Para aumentar el rendimiento a la hora de traerse las grabaciones, se pueden definir varias instancias de proceso recordCentral, este campo define cual de estas instancias se encargara de este nodo. 5.4.2 Vivait TrackerDesde VIVAit Supervisor, que es la aplicación dirigida a Supervisores, ofrece la posibilidad de supervisar y gestionar grupos ACD, agentes, asignaciones, prioridades,etc. Se puede obtener acceso directo a las aplicaciones de grabación (VIVAit tracker) Esquematico actual del proyecto tracker

2º Si la ubicación de la grabación es local, mira la ruta de esta y se procede a la escucha o descarga de esta. 3º Si la ubicación de la grabación es remota, entra en escena el proxy. Es el que realiza la petición. 4º Si utilizamos el tracker windows, este, como el tracker web, llama primero al web service remote login para la autenticación y tema de Permisos. 5º Para descargar o escuchar una grabación desde el tracker windows, se llama al web service servidor de grabaciones pasándole simplemente el ID de segmento.mp3. Este web service, con el ID de segmento, se encarga de determinar la ubicación de la grabación. Esquematico actual del proyecto tracker

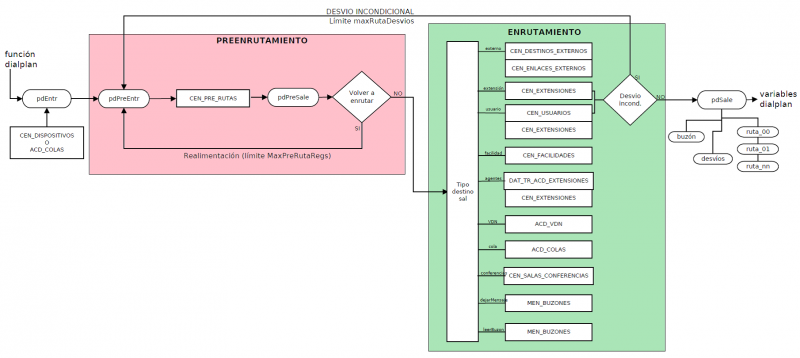

2º Si la ubicación de la grabación es local, mira la ruta de esta y se procede a la escucha o descarga de esta. 3º Si la ubicación de la grabación es remota, se realiza una petición al host remoto. El tipo de petición vendrá fijada por base de datos (http, https, ftp,ftps) 4º Si utilizamos el tracker windows, este, como el tracker web, llama primero al web service remote login para la autenticación y tema de permisos (comunicación https extremo a extremo). 5º Para descargar o escuchar una grabación desde el tracker windows, se llama al web service servidor de grabaciones pasándole simplemente el ID de segmento.mp3. Este web service, con el ID de segmento, se encarga de determinar la ubicación de la grabación. Volver arriba [Volver al indice] 5.5 Enrutamiento5.5.1 FuncionamientoEl proceso de enrutamiento, como vemos en el esquemático, se compone de dos fases:

Se asume que existen rutas directas entre todos los nodos de la red. Se asume que están directamente enrutadas todas las direcciones IP involucradas, tanto nodos, como terminales. Se asume que todas las facilidades están disponibles en todos los nodos, aunque es posible que la implementación sea diferente entre ellos. Los datos de entrada básicos al proceso de enrutamiento (pdEntr) son:

5.5.1.1 Fase preenrutamientoLa fase de preenrutamiento (basada en la tabla CEN_PRE_RUTA) se usa en todas las llamadas entrantes, tanto internas, como externas. Permite desarrollar un “prerouting” estándar para ACD y para telefonía corporativa. Los datos de entrada al proceso de enrutamiento son iguales a los del proceso global de enrutamiento, excepto en que este proceso no usa el nodo de entrada ya que es independiente de éste. Los datos de salida de la fase de preenrutamiento:

El proceso de preenrutamiento consiste en seleccionar un único registro de la tabla CEN_PRE_RUTA y, con sus valores y con los valores de entrada al proceso, generar los datos de salida. Un posible tipo de salida es "Volver a preenrutar". Esto permite realimentar el proceso un máximo de "max_pre_ruta_regs" veces (en archivo .conf) para simplificar configuración. Sólo tiene sentido realimentar si se ha hecho alguna modificación en los datos de selección de registro, ya que en caso contrario se produciría un bucle que el proceso de preenrutamiento es capaz de detectar y evitar. Para elegir el registro de CEN_PRE_RUTA, se tienen en cuenta los datos de entrada de la llamada, de modo que se cumpla con todos los puntos siguientes:

Si no se encuentra ninguna entrada adecuada, quiere decir que es una llamada prohibida y se devuelve el tipo de destino "No existe". Puede conseguirse un destino "por defecto" diferente, creando una entrada que encaje siempre para cada categoría: C_ORIGEN_ENT, C_ORIGEN_ENT_MIN_DIGITOS, C_ORIGEN_ENT_MAX_DIGITOS, C_ORIGEN_ENT_EXPR, C_DESTINO_ENT_PREF, N_DESTINO_ENT_MIN_DIGITOS, N_DESTINO_ENT_MAX_DIGITOS y C_DESTINO_ENT_EXPR a valor NULL. Una vez elegida una entrada, ésta puede transformar o sustituir el valor de ID_CATEGORIA, CALLER_NAME, CALLER_NUM, DESTINO, COD_CLIENTE y/o EJE1_MSK a la salida del proceso. Si ID_CATEGORIA_SAL es cero, se propaga a la salida el valor de la entrada. En caso contrario, se sustituye. Si C_CALLER_NAME está vacío, se mantiene el valor hubiese a la entrada. En caso contrario, se sustituye. C_CALLER_NUM puede contener una cadena que identifica el nuevo CALLER_NUM. Además, si la cadena comienza por los caracteres que se indican, el significado es especial: